一、前言

最近我们监测到两则情报,似乎有一定联系。

1、跨国公司香港办事处因骗子举办深度伪造视频会议而损失 2 亿港元

2、OpenAI 正在为 DALL-E 3 添加新水印

第一则信息是利用DeepFake去伪造视频诈骗,第二则是OpenAI给图片增加水印。

也的确自从大模型大火之后,利用AI辅助生成话术、声音、图片、视频等去减少诈骗的成本并提高诈骗使用素材的质量,因此被诈骗的新闻报道也屡见不鲜了。

那如何甄别AI生成的内容?以及如何防范呢?

二、真假难辨视频换头

1.1、低成本换头

视频换头技术早在2018年就爆火了,并且有很多项目在github开源简单化使用。

https://github.com/serengil/deepface

https://github.com/iperov/DeepFaceLab

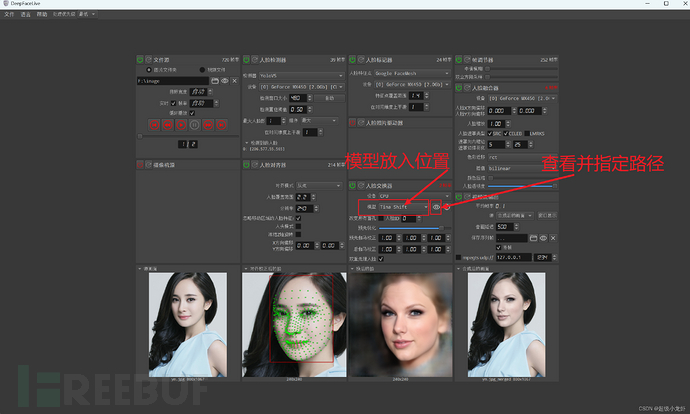

DeepFaceLab提供了各种系统版本,如在windows的图形化界面进行伪造。

甚至有可以在线付费,非常容易上手。

https://www.deepswap.ai/signup

AI甚至可以帮你生成一个完全伪造的视频,如下图使用runway生成主题“钢铁侠在都市城市”。

1.2、如何识别?

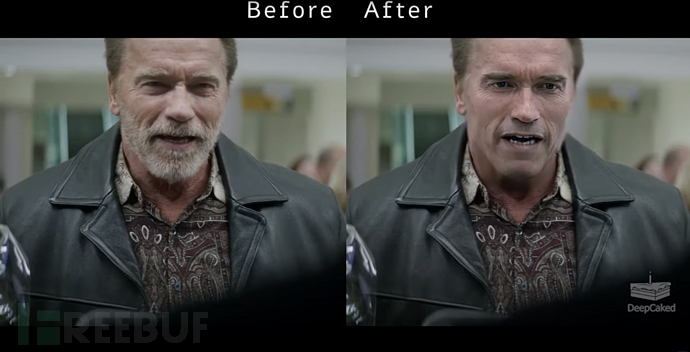

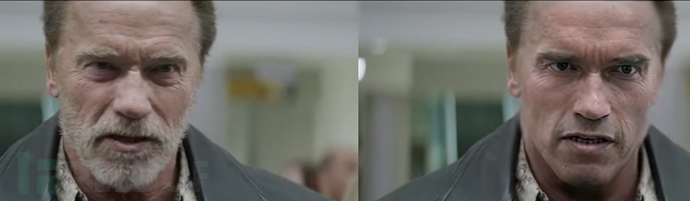

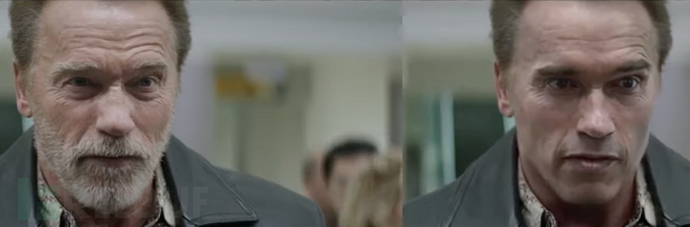

我们拿DeepFaceLab中的一个官方demo进行举例。

https://www.qq.com/watch?v=Ddx5B-84ebo

这里能够找到明显的四处缺陷

1、融合边缘区不自然,脸部和脖子的交界处皮肤明显不一样,左图交界处的皮肤有明显的皱纹而有图没有。

2、牙齿的纹理,右图牙齿没有纹理,看上去就是一个白块。

3、眼睛的纹理,右图的眼睛同样没有纹理,白色区域非常白。

4、环境阴影问题,脖子处有阴影说明光源是在头部,而且右图的眼睛下面没有阴影,而左图有。

如果连续仔细观察,发现视频帧与帧之间变化也挺大的,

二、总搞点新闻的假图片

2.1、PS? AI生成?

说到文生图,就不得提到了midjourney、stable diffusion,

midjourney生成的自然风景。

stable diffusion生成的模特

以及AI生成的特朗普在逮捕的图片。

2.2、如何识别?

识别图片还是跟识别伪造视频的方法思路大致一样,还有有一些特性:

1、第一张,自然风景,观察到midjourney生成图的对比度非常高。

2、第二张生成人物,stable diffusion生成的人物的手指尤其不正常。

3、第三张生成的人物,很明显没有皮肤纹理。

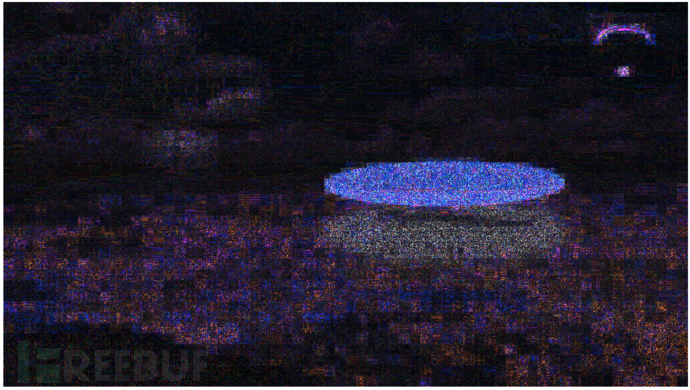

除此之外,还有工具ELA:

误差水平分析法(Error Level Analysis,ELA)。原理是通过分析JPEG图片各区域的压缩率并计算其误差水平,来判断该图片是否进行过PS拼接、修改、涂抹等后期处理。原则上,只进行一次采样获得的原始JPEG图片,各区域的ELA值应该是相似的,如果出现一块区域ELA值显著异于图片其他部分,则这一块区域很可能是后期修改过的。

比如常用的网站:https://29a.ch/photo-forensics/#error-level-analysis,很容易识别出中间那个UFO、以及跳伞的为PS。

这个网站可以检测相同的元素,判断是否有PS的痕迹,是一款很棒的工具。

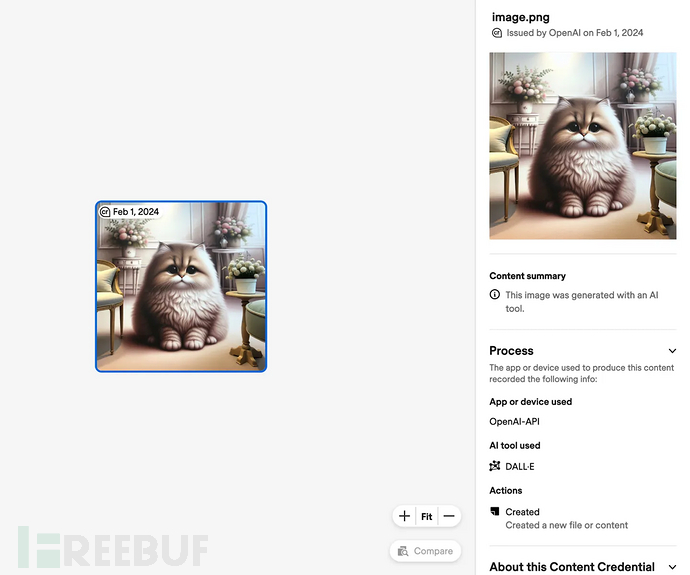

目前OpenAI最近也着手去缓解这个问题,开始使用C2PA验证了,目前增加照片的元属性以及增加标志。

https://help.openai.com/en/articles/8912793-c2pa-in-dall-e-3

于是环顾了国内的大模型,可以说是遥遥领先,都增加了水印。

文心一言

豆包

通义千问

三、文本-大模型生成识别

特征的选取一般分为统计特征,语言特征和事实特征。其中统计特征一般是用来检查大型语言模型生成文本是否在一些常用的文本统计指标上于人类文本不同,常用的有 TFIDF、齐夫定律等。语言特征一般是找一些语言学特征,比如词性,依存分析,情感分析等。最后,大型语言模型常常会生成一些反事实的言论,因此事实验证也可以提供一些区分大型语言模型生成文本的信息。

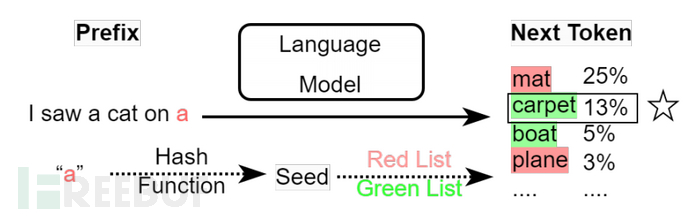

目前的检测方法可以分为 post-hoc 水印和 inference time 水印:

其中 post-hoc 水印是在大型语言模型生成完文本后,再在文本中加入一些隐藏的信息用于之后的检测;

Inference time 水印则是改变大型语言模型对 token 的采样机制来加入水印,在大型语言模型生成每一个 token 的过程中,其会根据所有 token 的概率和预设的采样策略来选择下一个生成的词,这个选择的过程就可以加入水印。

不过目前均不太好落地,如果采用inference time 水印,则会影响生成的效果与质量。

采用post-hoc,虽然可以减少对生成的文本影响,但还是会有影响。

适用了一批检测AI生成文本的工具,效果均不是很理想。

https://contentatscale.ai/ai-content-detector/

四、声音-变声器如何识别?

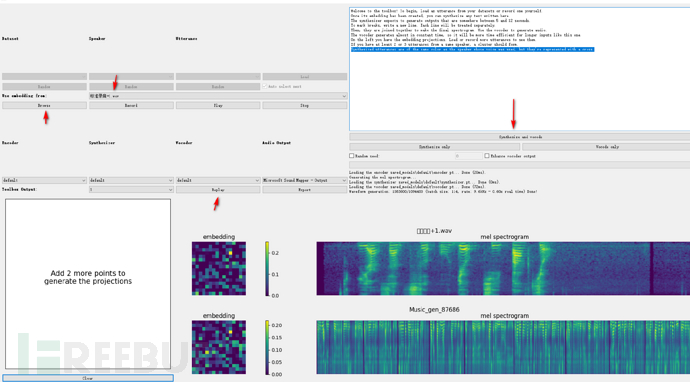

github上面也有开源的项目,这个项目目前只支持英语。

https://github.com/CorentinJ/Real-Time-Voice-Cloning

国内有人支持了中文根据Real-Time-Voice-Cloning项目支持了中文:

MockingBird/README-LINUX-CN.md at main · babysor/MockingBird · GitHub

不过这里尝试效果不是很好,需要大量被模仿人的语音训练才能勉强合格。

这让我想起变声器,之前看过看一些视频介绍变身器以及效果展示,感觉听不出异常,后面也调研一下他们怎么做的。

至于如何识别?

1、声音比较大时声音失真

2、识别杂音(比如敲击键盘是否有异常)

3、音高、音强、音长、音色(通过声纹确认)

五、结语

视频、声音、图片、说话方式都可以通过AI去模仿,而且模仿成本比较低,容貌、声音这些生物特征很容易接触。不敢想象,未来跟你网络通信的另一端到底是真的他吗?

所以检测是否AI是很重要的一个方向,但目前国内好像没太注重?

历史AI文章可以查看:微信公众号 lufeirider

六、参考

冒充人类作者,ChatGPT等滥用引担忧,一文综述AI生成文本检测方法 - 腾讯云开发者社区-腾讯云

4A评测 - 免责申明

本站提供的一切软件、教程和内容信息仅限用于学习和研究目的。

不得将上述内容用于商业或者非法用途,否则一切后果请用户自负。

本站信息来自网络,版权争议与本站无关。您必须在下载后的24个小时之内,从您的电脑或手机中彻底删除上述内容。

如果您喜欢该程序,请支持正版,购买注册,得到更好的正版服务。如有侵权请邮件与我们联系处理。敬请谅解!

程序来源网络,不确保不包含木马病毒等危险内容,请在确保安全的情况下或使用虚拟机使用。

侵权违规投诉邮箱:4ablog168#gmail.com(#换成@)